deepseek怎么部署 deepseek部署到本地教程

在2025 年的 ai 技术界,来自深度的求索推出的 deepseek 正在掀起一场风暴。这款 ai 大模型自 1 月 11 日上线以来,其强劲的性能堪比 openai 的 o1 正式版 deepseek-r1,引发了广泛轰动,甚至撼动了 chatgpt 的市场地位和全球 ai 格局。php小编香蕉将带您深入了解 deepseek 的性能、应用和对 ai 产业的影响,为您揭示这一革命性技术背后的故事。

然而,DeepSeek因频繁遭受网络攻击和访问量过大,导致用户经常遇到“服务器繁忙”提示,影响使用体验。

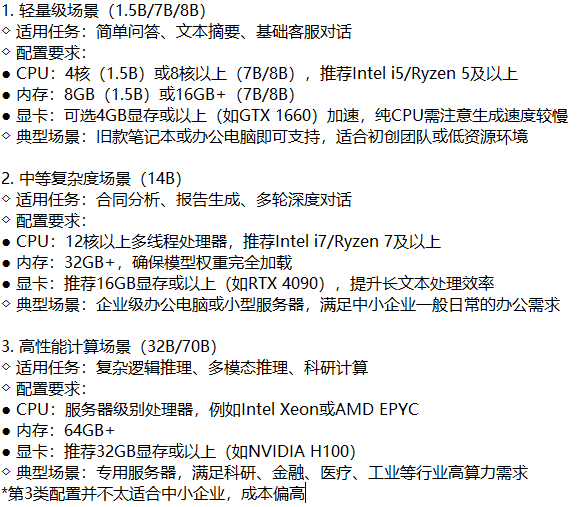

解决方法之一是本地部署DeepSeek大模型。虽然此方法对电脑配置要求较高,普通用户可能只能部署性能较低的版本,但对于要求不高且对信息时效性要求不高的用户来说,仍然是一个可行的选择。以下步骤将指导您完成DeepSeek本地部署:

使用Ollama本地部署DeepSeek-R1大模型教程(适用于大多数大模型)

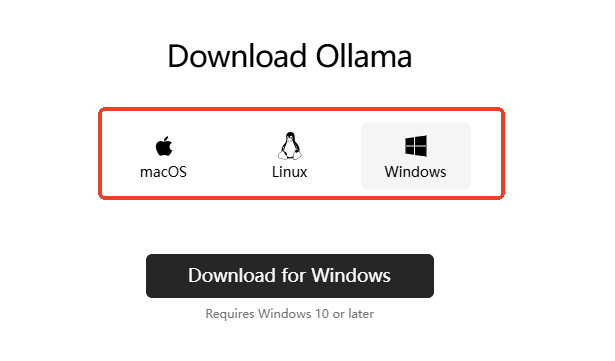

第一步:安装Ollama

Ollama是一个开源框架,允许您在本地运行大型语言模型。访问Ollama官网 (https://www.php.cn/link/838dc9de386130f83f625a98d1ea561f) 下载适合您系统的版本并安装。安装完成后,将出现一个命令行界面,Ollama本身没有图形界面。

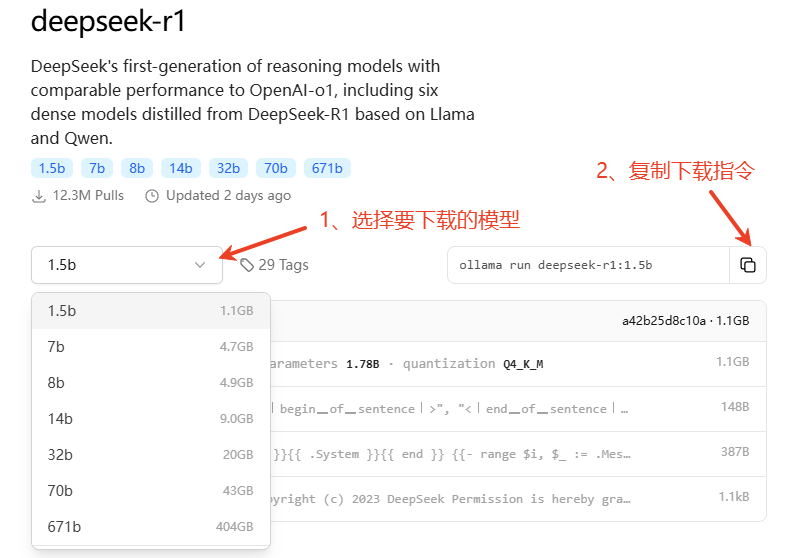

第二步:下载DeepSeek-R1模型

访问Ollama模型库 (https://www.php.cn/link/838dc9de386130f83f625a98d1ea561flibrary/deepseek-r1),选择合适的模型版本(例如1.5b版本),复制其下载命令。

DeepSeek-R1模型规格参考:

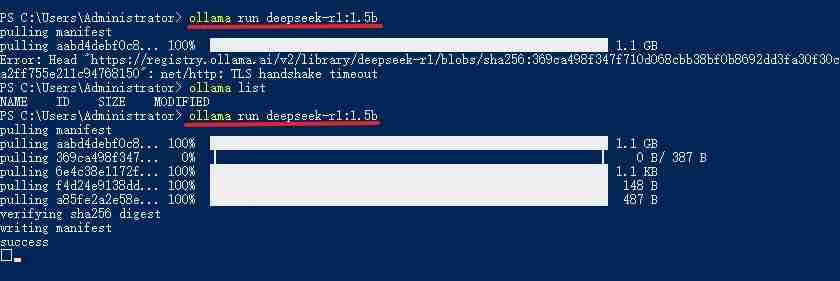

将复制的命令粘贴到Ollama命令行中运行,下载速度取决于您的网络连接。下载完成后,命令行会显示“success”。

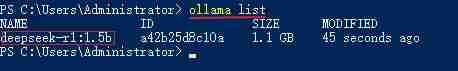

输入“ollama list”命令查看已下载的模型。 如果显示模型列表,则表示下载成功。

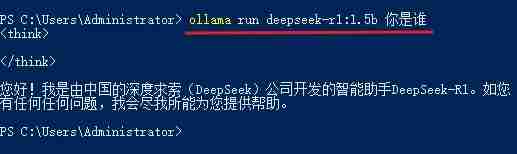

然后,在命令行输入 ollama run deepseek-r1:1.5b+你的问题 (或 ollama run deepseek-r1:7b+你的问题 ,取决于您下载的模型版本)即可开始对话。

为了提升使用体验,建议使用第三方AI客户端。

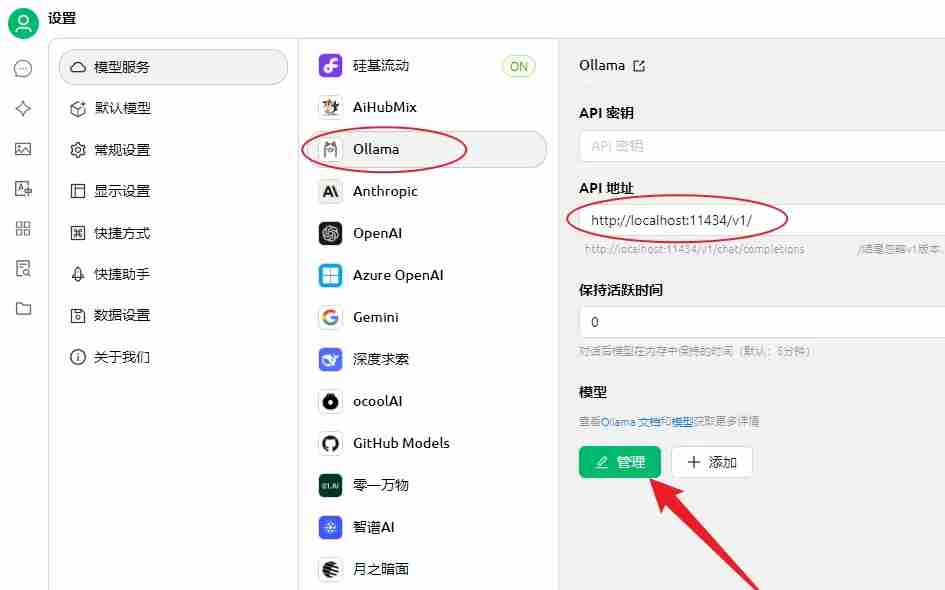

第三步:使用Cherry Studio调用模型

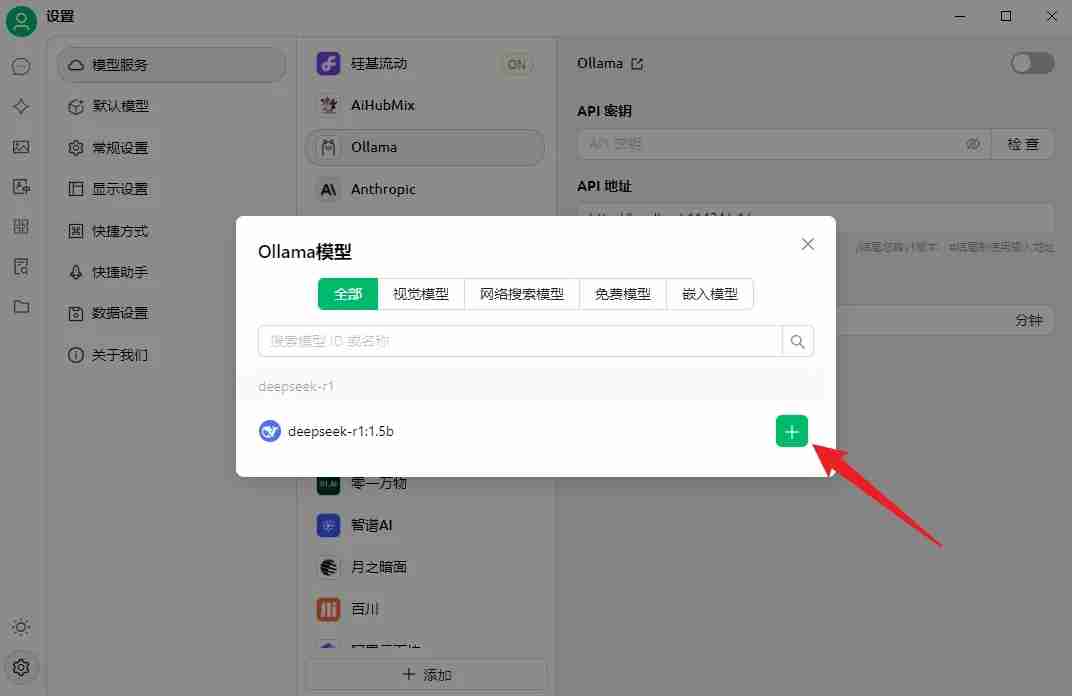

下载并安装Cherry Studio (https://www.php.cn/link/838dc9de386130f83f625a98d1ea561f)。在设置中选择“Ollama”,API地址会自动填充。点击“管理”,添加您已下载的DeepSeek-R1模型。

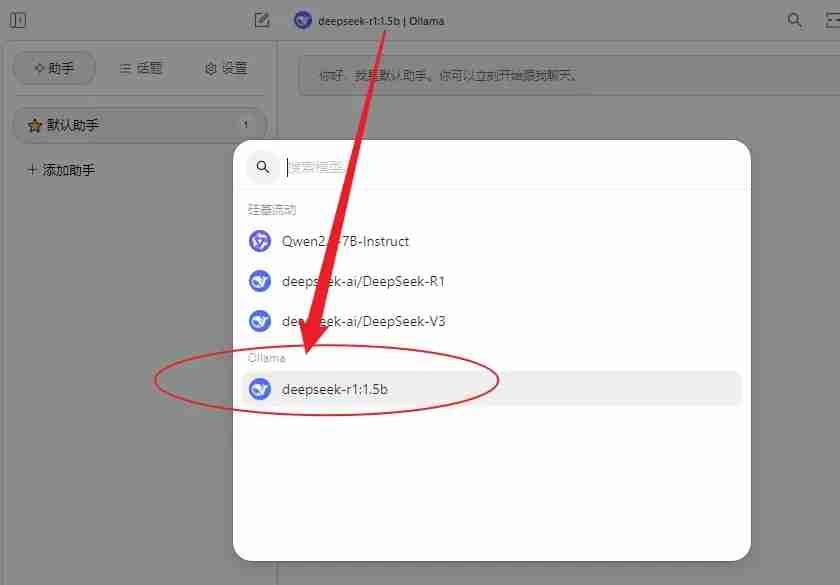

最后,在Cherry Studio的对话界面选择DeepSeek-R1模型即可开始使用。

通过以上步骤,您便可在本地运行DeepSeek大模型,享受更稳定流畅的AI体验。

最新推荐

-

miui11透明壁纸怎么设置 小米11设置透明壁纸

miui11透明壁纸怎么设置?通过让自己手机的壁纸显得透明,看起来更有个性,在miui11中,自带了设置透 […]

-

wps的文档怎么设置密码保护 wps文档加密设置密码

wps的文档怎么设置密码保护?wps文档不仅支持用户自由的编辑文本数据,也支持用户对自己隐私进行保护,通过 […]

-

win7开机自动启动软件怎么关 win7系统禁用开机启动项在哪

win7开机自动启动软件怎么关?在电脑使用过程中,用户安装的软件应用都会默认在电脑开机时候自己启动,这就导 […]

-

win11截图保存路径怎么改 win11截图在哪个文件夹

win11截图保存路径怎么改?很多用户都会对想要保存的图片素材进行截图保存,那在win11系统中,截图默认 […]

-

win10桌面图标有防火墙标志怎么办 电脑软件图标有防火墙的小图标怎么去掉

我们的桌面图标总是想要保持美观,但有时候会发现上面多了几个电脑防火墙的标志,变得很丑,那么win10桌面图标有防火墙标志怎么去掉呢。

-

怎么把默认显卡改为独立显卡 win10显卡切换到独显

怎么把默认显卡改为独立显卡?独立显卡的性能优于主板自带的集成显卡,现在许多电脑都配备了双显卡,然而许多用户 […]

热门文章

miui11透明壁纸怎么设置 小米11设置透明壁纸

2wps的文档怎么设置密码保护 wps文档加密设置密码

3win7开机自动启动软件怎么关 win7系统禁用开机启动项在哪

4win11截图保存路径怎么改 win11截图在哪个文件夹

5win10桌面图标有防火墙标志怎么办 电脑软件图标有防火墙的小图标怎么去掉

6怎么把默认显卡改为独立显卡 win10显卡切换到独显

7华硕笔记本怎么设置ssd为第一启动盘 华硕电脑设置固态硬盘为启动盘

8win10锁屏设置幻灯片自动播放不生效怎么解决

9win7与win10如何建立局域网共享 win10 win7局域网互访

10笔记本win7怎么创建wifi win7电脑设置热点共享网络

随机推荐

专题工具排名 更多+

闽公网安备 35052402000378号

闽公网安备 35052402000378号